Astrofotografie eine andere Art von Fotografie.

Irgendwann packt es den Einen oder Andern, sich abseits der „normalen“ Fotografie zu versuchen. Am besten einfach probieren, dann sieht man früher oder später, wo die Problemzonen liegen. Hier versuche ich mal darauf einzugehen.

Vorweg: Gerade Anfangs versteht man oft nicht immer gleich, worum es da überhaupt geht und so erhält man rasch den Eindruck: Das ist mir zu Hoch, dass schaff man nie!

Auch mir ist es so ergangen beim initialen Einlesen in die Thematik um mir ein Bild zu machen, was bräuchte ich an Ausrüstung und ob ich das jemals selbst hinbekommen würde. Heute nach 3,5 Jahren bereue ich nicht, diesen Schritt gewagt zu haben.

Das was einem wohl als erstes auffällt:

Belichtungszeit

Sehen wir uns mal ein normales Foto an:

Ein typisches Urlaubsbild. F/10, 1/200s, ISO100 (damals mit der E-300 die Nennempfindlichkeit)

Das Histogramm zeigt uns die Anzahl und Helligkeitsverteilung der Pixel der roten, grünen und blauen Pixel an aus denen ja ein Farbbild (RGB Bild) besteht. Links im dunklen Bereich und rechts im hellen Bereich ist nichts wesentliches weggeschnitten. Da braucht es nicht viel Bearbeitung – vielleicht den dunklen Bereich der fast schwarzen Lava etwas anheben um noch Struktur zu generieren und das Bild halt auf das gewünschte beschneiden.

Ein Stativ braucht man hier kaum, die Belichtungszeit ist kurz genug als dass man verwackeln könnte.

Fotografiert man in JPG wird man aber bei diesem Bild wegen des großen Helligkeitsumfanges (weiße Mauer – fast schwarze Lava im Schatten) schon mal merken, dass man beim Spielen mit dem Tonwerten im Himmel sogenannte Tonwertabrisse ( Sichtbare Streifen abgestufter Helligkeit) bekommt. Grund ist der: Beim JPG Bild haben die 3 Farbkanäle eine Bittiefe von 8bit, was 256 (2^8) möglichen Abstufungen entspricht. Mehr als unser Auge sehen kann und zusammen gemixt (256*256*256) die bekannten 16,7 Mio unterschiedliche Farbabstufungen ergibt (siehe: Die richtige Belichtung). Dehnt man dann gezielt einen Bereich im hellen oder dunklen, sieht man dann bald mal die Helligkeitssprünge am Ergebnis. Abhilfe ist dann in RAW zu fotografieren, den sie bieten hier 12bit Auflösung, was schon 4096 Abstufungen pro Farbkanal entspricht, also kann man hinterher mehr „herauskitzeln“.

In der gelebten Praxis: Bei gut ausgeleuchteten Alltagsszenerien reicht oft das JPG, so wie es aus der Kamera kommt. Bei schwierigen Situation ist ein zusätzliches RAW empfohlen, Auch wenn man jetzt vielleicht damit nichts anfangen kann – später vielleicht doch. In der Astrofotografie ist RAW Pflicht.

Solche Verhältnisse findet man auch noch an unseren zwei hellsten Himmelskörpern: Mond und Sonne (natürlich nur durch entsprechende dafür geeignete Spezialfilter). Sie erlaube auch Belichtungszeiten zwischen angenehmen 1/100-1/4000 Sekunden bei normaleren ISO Bereichen. Ein Stativ ist dennoch empfohlen!

Anders am dunklen Sternenhimmel:

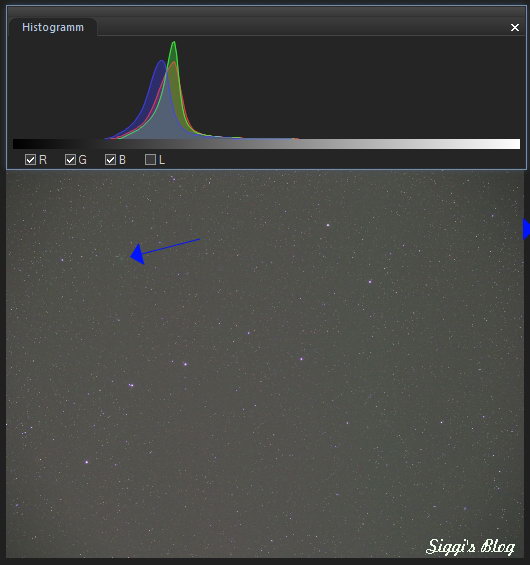

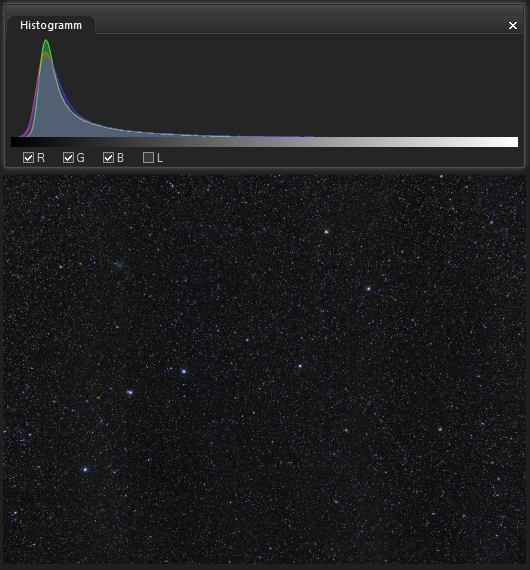

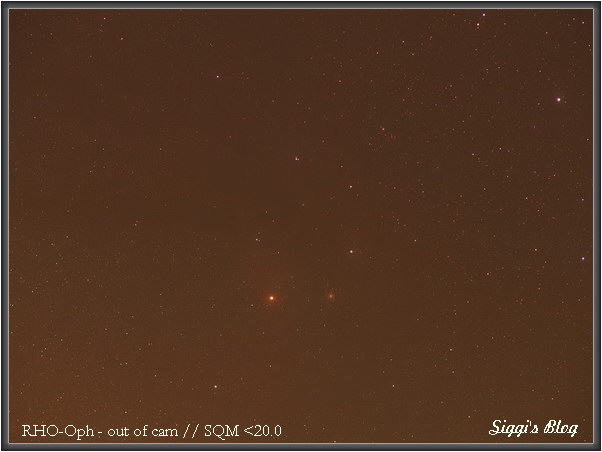

Es zeigt den Große Wagen mit einem Normalobjektiv (bei Olympus 25mm). Es wurde typischerweise so belichtet, wie man es für „Deep Sky“ Bilder braucht.

Die Belichtungsdaten waren: F/3,2, 240s, ISO800 mit der E-M1.II (geht auch mit jeder anderen OM-D oder E-PL6-9 Kamera so). Einfach ein Screenshot ohne Bearbeitung wenn ich es in ACDsee ansehe.

Wer jetzt mal nachrechnet kommt drauf, dass man hier typischer weise mit 500.000 bis weit über 1 Million mal weniger Licht hat. Um entsprechendes Signal am Sensor zu bekommen, dass auch über dem Rauschen liegt, muss man entsprechend lange belichten.

Was zeigt uns das Histogramm: Zunächst mal die vielen Pixel des Himmelshintergrund. Sie liegen im 1/3 des Histogramms. Da die Darstellung nicht linear ist, heißt das nicht unbedingt dass man auch tatsächlich 1/3 der Gesamtbelichtung des Sensorpixel ausgeschöpft hat. Aber immerhin liegt der Himmelshintergrund deutlich von stark verrauschten linken Rand weg.

Wichtiger ist aber das, was man nicht sieht: Die paar Pixel der hellen Sterne. Das sofort ins Auge fallende Muster der hellen Sterne, die das Muster bilden. Die sind so hell, dass man sie bei uns in der Großstadt sehen kann. Natürlich sind die im Zentrum überbelichtet. An sich sollten sie ja punktförmig sein, aber das Flimmern der Luft weitet das Signal auf eine größere Fläche, was wiederum die Helligkeit durch Verteilung stark absenkt und es so möglich macht dennoch die Farben ins Spiel zu bringen. Überbelichtete haben ja alle Pixel gesättigt, was dann ja ein reines weiß ergibt.

Auch wenn die Sterne sehr hell sind, die geringe Anzahl der hellen Pixelwerte kommt gegen die extrem vielen Pixel im dunkleren Bereich nicht an, wird also am rechten Rand des Histogramms nicht mehr angezeigt.

Man sieht auch dass der Grüne Anteil relativ hell ist, das ist der typische Landhimmel etwas weiter weg einer Großstadt. Der Himmel so „OOC“ (out of Cam) also wie die Kamera den Weißabgleich macht, ist schon recht gut dafür, dass sie nicht für solche extreme Situationen programmiert ist. Einen richtigen Weißabgleich erkennt man daran, dass die 3 Buckel der RGB Kanäle exakt übereinander liegen. Das gilt natürlich nur da, wo man wirklich neutralen Himmel hat.

Und was man schwer sieht, hätte ich es nicht markiert: Da war gerade ein Komet (P41/Tuttle-Giacobini-Kresak) und auf diesem kleinem Bild gar nicht sieht, wenn man nicht weiß wo: Die Feuerrad-Galaxie (M101) eine bekannte Galaxie von der Größe des Vollmondes und M51. Um solches geht es uns bei der Fotografie von Deep Sky Objekten (Objekte außerhalb des Sonnensystems). Misst man deren Helligkeit würde man sehen: Sie liegt an der rechten Flanke des Histogrammbuckels bis leicht davor. Während man hellere Kometen durch das große diffuse leuchten schon mal finden kann, eine Galaxie wie M101 oder M51 kaum mehr am Rohbild.

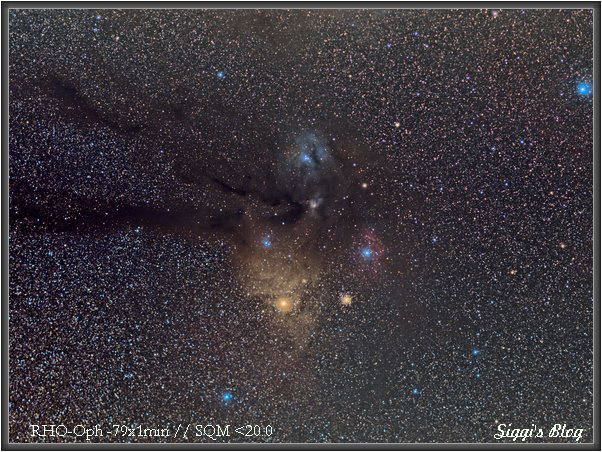

Auf vielen, sogenannten „tief belichteten“ Bildern wird man jede Menge Staub und Dunkelwolken erkennen. Tatsächlich gibt es keinen Bereich am Himmel, bei dem man mit nicht mit genügend langer Belichtung und vor allem Akribie bei der Ausarbeitung keinen sehen wird. Diese Bereiche liegen vor dem Himmelshintergrundbuckel.

Also hinterher einfach das Bild so zu beschneiden, dass man alles weg wirft, dass vor dem Peak (der ja dem Himmelshintergrund entspricht) liegt führt zwar zu einem schön dunklen Himmel, aber auch zum Vernichten von der schwachen Strukturen.

Die nötigen langen Belichtungszeiten bringen eine Vielzahl an weiteren Problemen mit sich.

Bildrauschen

Gerade in der „normalen“ Fotografie wird das extrem überbewertet. Je wärmer, desto mehr rauscht ein Sensor, das ist einfach so. Das Rauschen setzt sich aus verschiedenen Fehlerquellen zusammen: Jeder Sensor hat Pixel, die nicht so arbeiten wie sie sollen. Belichtet man länger, dann fallen sie einem stärker auf. Durch einen Dunkelbildabzug ist das beherrschbar.

Schon schwieriger ist das Rauschen das nach Dunkelbildabzug im Bild verbleibt. Und da hilf nur eines: Möglichst viele Bilder zusammenrechnen.

Die Spezialkameras für Astrofotografie sind daher auch gekühlt, damit man auch ein möglichst gutes Signal/Rauschverhältnis bekommt.

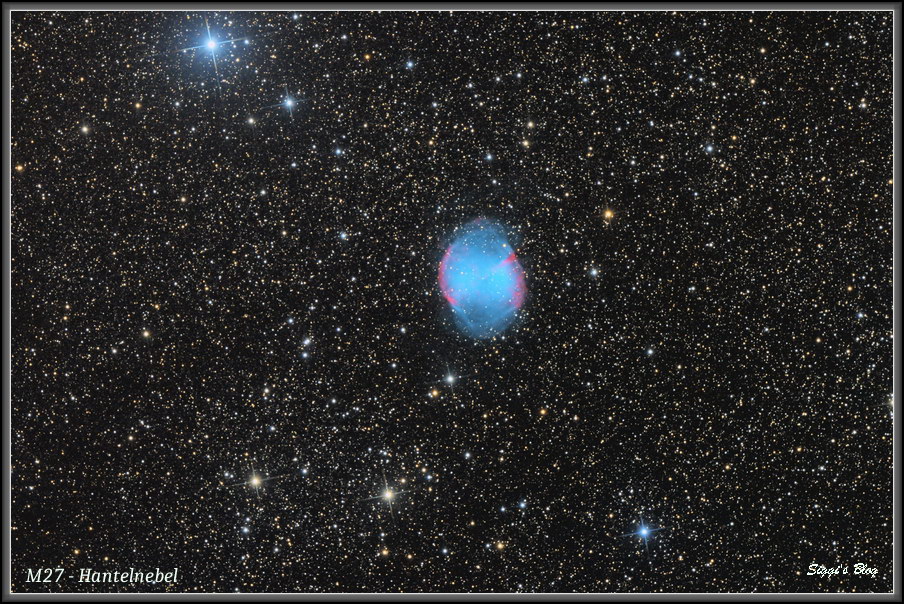

Hie mal das Bild von vorhin nach zusammenrechnen von 43 Bildern

In groß und noch größer findet man das Bild auf

AstroBin

Stativ/Montierung

Auch sehr schnell merkt man, dass man mit einem fixen stabilen Fotostativ jenseits von extrem Weitwinkel schnell an die Grenzen des Lichtsammeln stößt. Man braucht also eine Nachführung. Für den Einsatz mit Fotoobjektive gibt es gut und günstige Tracker. Die Sache wird aber immer schwieriger sobald die Brennweite steigt braucht es mehr Präzision in der Nachführung. Dazu kommt: Je mehr Brennweite, desto geringer die „bezahlbare“ und vom Gewicht her auch handhabbare minimale Blendenzahl. Man muss dann auch noch zusätzlich länger Belichten um die nötige Lichtmenge zu sammeln.

Bei größeren Brennweiten benötigt man dann eine richtige Montierung. Sie muss präzise auf den Himmelspol eingerichtet werden, aber selbst da wird man ab einer gewissen Brennweite nicht mehr ohne Guiding wegkommen.

Ein sehr gute Montierung ist meist der teuerste Teil einer guten Astrofotoausstattung, aber wenn man sie gut dimensioniert auch nur einmal anzuschaffen. Ohne präzise Nachführung werden auch die Einzelbilder aus den besten Teleskopen / Linsen und Fotoapparaten nichts.

Bildbearbeitung

Um aber aus den gestackten Rohbildern wirklich etwas herauszuholen, bedarf es einer tiefergehenden Bildbearbeitung. Man muss sehr vieles sehr selektiv verstärken, ohne Anderes überzugewichten oder gar zu zerstören. Dazu sind Maskentechniken ein muss. Nach der Gewinnung der Rohbilder ist das dann der größte Teil, der im wesentlichen nur mehr von der eigenen Vorstellung und seinem Vermögen das auch umsetzen zu können begrenzt wird. Das ist ein wohl ewiger Prozess. Während man für die Technischen Aspekte nach einigen Tipps aus der Gemeinschaft sehr viel selber herum tüfteln kann, ist man bei der Bildbearbeitung sehr viel mehr auf eine funktionierende Community angewiesen, deren Tipps und Tricks einem wieder weiterbringen.

Hier ein Bild mit dem 75mm Objektiv:

Links unten M101 und Rechts unten:

M51 wie man sieht sie sind auch mit normaler Brennweite auffindbar.

Auflösung

Unter normalen Umständen macht sich die Luft bei der normalen Fotografie nicht stark bemerkbar. Anders natürlich bei extremeren Tele auf größere Entfernungen, wo man sich schon mal bei Sonneneinstrahlung Luftschlieren zu sehen sind. Bei der Astrofotografie hat man da schon mit ganz anderen Schichtdicken zu tun: Im Zenit etwas über 10km, blicken wir Richtung Horizont sind es einige hunderte Kilometer dichte Luft. Dazu kommt noch Dunst und der Umstand, dass eine Auftrennung der Farben stattfindet. Ein weißer Stern hat dann auf einer Seite einen roten Rand, auf der anderen Seite einen blauen.

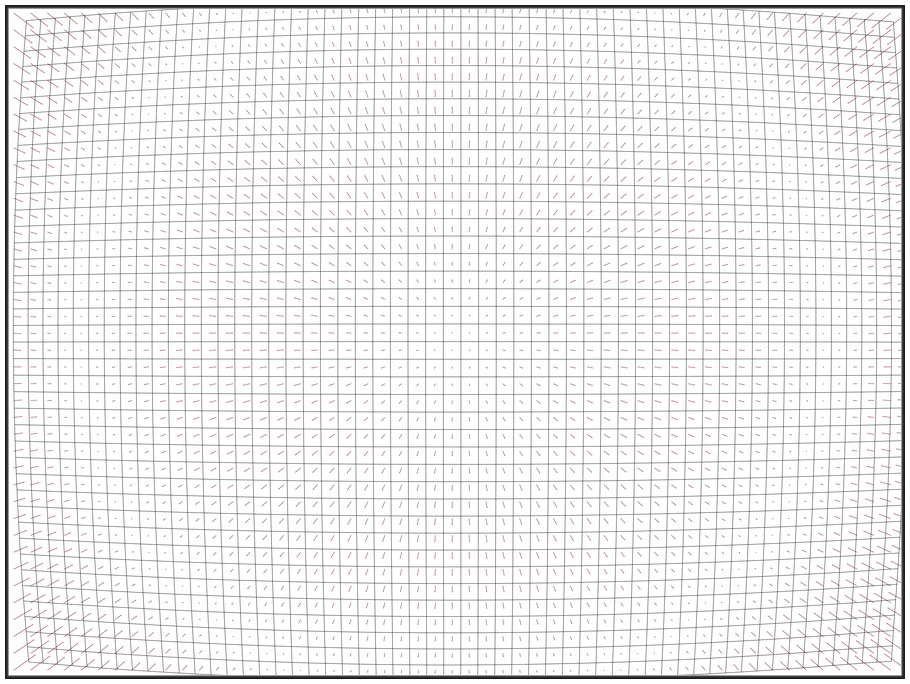

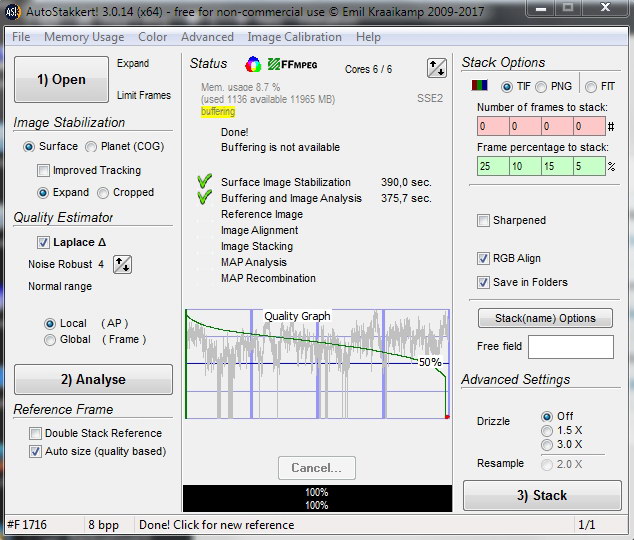

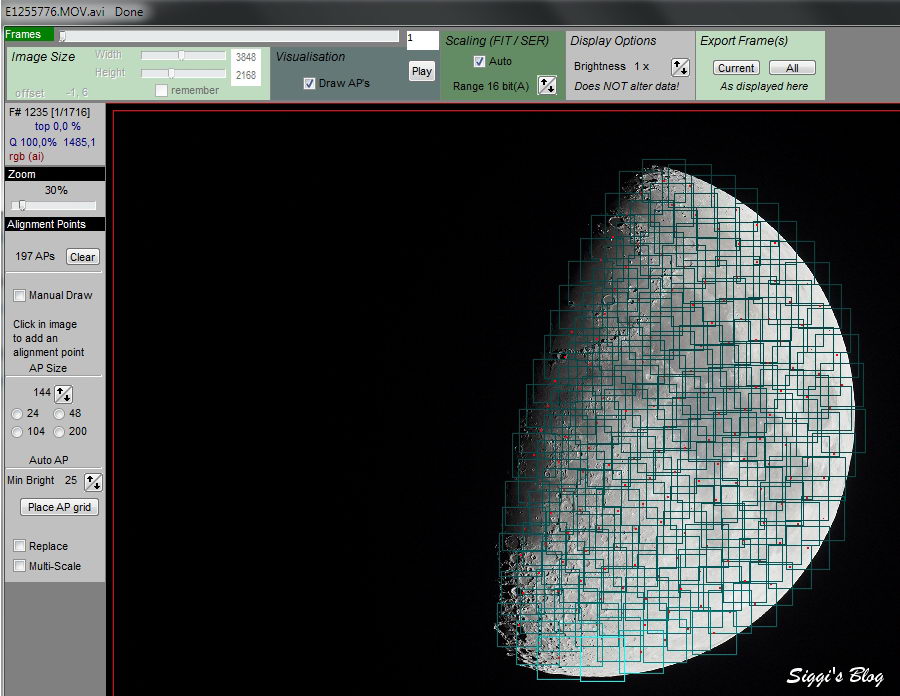

Dazu kommt: Leider gibt es meist in hohen Luftschichten starke Winde (Jetstreams), die die Luftschichten zusätzlich verwirbeln. Das ganze läuft unter Seeing. Das mindert natürlich auch die mögliche Auflösung. Auch da ist ein Mitteln vieler Bilder das Mittel der wahl. Zuvor wird natürlich versucht, aus den vielen Einzelbilder jene mit dem stärksten Unschärfen zu eliminieren.

Scharfstellen

Heutzutage sorgt der Autofokus für scharfe Bilder. Bei der Astrofotografie ist manuelles Scharfstellen gefragt. Bei längeren Brennweiten geht das mit Hilfe einer Bahtinovmaske recht einfach an einem hellen Stern. Je geringer die Brennweite, desto schwieriger wird es, weil der Stern ja immer winziger wird, und man bräuchte eine passende Bahtinovmaske, dafür kommt aber bei recht weitwinkeligen Objektiven dazu, dass sie eine größeren Schärfenbereich aufweisen. Die Situation wird aber durch die notwendige möglichst offene Blende verschärft. Offene Blende braucht man aber, weil man dann einfach mehr Licht einsammeln kann.

Das ganze wäre ja nicht so schlimm, einmal gut Scharfstellen, dann passt es die nächsten 2-3 Stunden Belichtungszeit. Leider ist das nicht so. In der Nacht sinkt normalerweise die Temperatur ab. Das führt zu einem verstellen der Schärfe. Also ist recht oft die Schärfe zu kontrollieren, gerade anfangs. In der Praxis ist es aber meist so, dass man an der Kamera sein Bildfeld schwer erkennen kann, weil man schlicht und ergreifend nichts sieht! Man braucht dann wieder einen Stern der hell genug ist zum Scharfstellen und muss erneut sein Objekt wiederfinden. Man braucht dann länger belichtete Testbilder mit sehr hoher ISO um eine Feineinstellung vorzunehmen. Das betrifft vor allem Fototracker, die man händisch verstellt. Bei guten Astromontierungen hat man es mit GoTo leichter. Wenn sie einmal gut eingestellt sind, findet man hinterher sein Objekt wesentlich leichter. Wenn man dann mal mit Schmalbandfiltern anfängt wird es dann extrem schwierig überhaupt ein geeignetes Objekt zu finden, um scharf zu stellen.

Für Teleskope gibt es Motorfokussysteme, die mithilfe eines Temperatursensors präzise einen vorher ermittelten Wert einstellen.

Das Problem der temperaturabhängigen Fokusänderung betrifft so gut wie alle. Einzig Systeme mit wesentlich temperaturstabileren Kohlefasertuben mit passendem Spiegel (Pyrex oder Quarz) und Stabilem Okularauszug verstellen sich praktisch kaum. Zum Glück trifft das alles auf meinen „Newton ohne Namen“ zu.

Störungen im Optischen System

Sehr gute Linsensysteme sind meist recht gut korrigiert, sodass möglichst alle Farbstrahlen im selben Brennpunkt landen. Die extreme Streckung der schwächsten Bildanteile bringt hier allerdings wieder vieles ans Licht, das man so nicht sieht. Jede Grenzfläche einer Linse, jeder Reflex am Gehäuse wird natürlich auch sichtbar. Und jede Linse kostet Auflösung. Da kommen Spiegelsysteme ins Spiel. Das tolle daran ist: Sie sind Farbrein, jede Lichtwellenlänge landet im selben Brennpunkt. Je größer der Spiegel (die Öffnung) desto mehr Licht wird gesammelt und die Auflösung steigt auch.

Eine „Linsen“ Teleskop mit mit 200mm Öffnung ist kaum bezahlbar, ein Spiegel mit 200mm schon…..

Bildstörungen wie Staub am Sensor fallen in normalen Bildern kaum auf, außer man hat eine uniforme Fläche (wie z.b. Himmel) und bei kleinere Blende. Jedes Objektiv hat auch einen mehr oder weniger großen Helligkeitsabfall gegen den Rand. Bei der Astrofotografie braucht man aber ein möglichst „flaches“ Bildfeld. Also müssen diese Bildfehler herausgerechnet werden. Das wird mit sogenannten Flat Bildern bei der Bildkalibrierung erreicht.

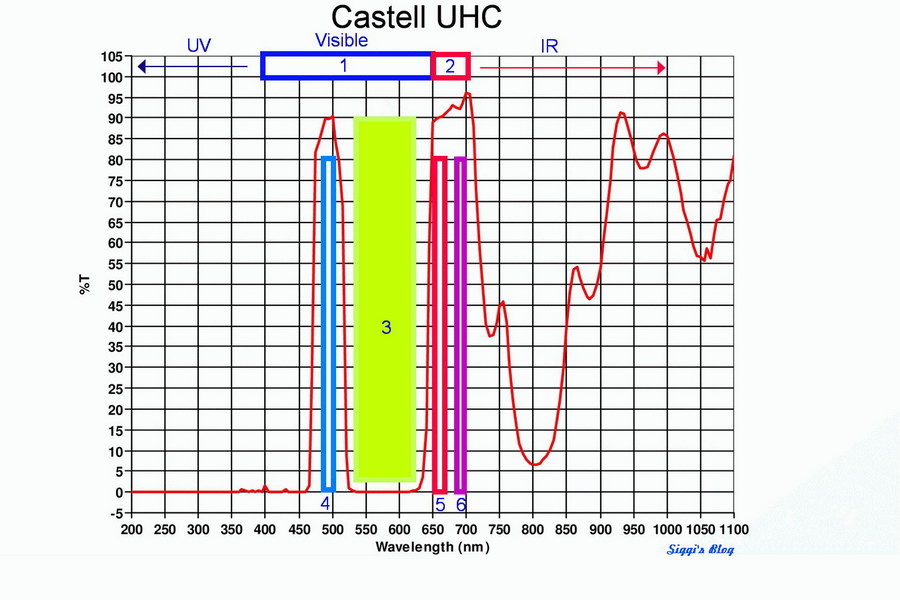

Echte Farben?

In der normalen Welt, weiß jeder, was in etwas stimmig an Farben ist, wir sind darauf konditioniert. Alles was abweicht von dieser Erfahrung erzeugt eine Unstimmigkeit. Selbst wenn wir nicht genau wissen was an diesem Bild „falsch“ ist. Selbst unser an Dunkelheit angepasstes Auge sieht bei einem Blick durch ein größeres Teleskop so gut wie keine Farben. Das rote Leuchten des Wasserstoffs liegt schon in einem so dunklem roten Bereich, dass wir kaum mehr wahrnehmen können. Unsere Digitalkameras filtern diesen Bereich sogar schon zu 2/3 heraus. Selbst wenn wir uns im dunklen Weltraum befänden und auf den sehr hellen Orion Nebel zusteuern würden, wir würden das schwache rote Leuchten kaum sehen. Je näher wir kommen, desto mehr wird das Leuchten untergehen. Es sind ja bloß ein paar 100- maximal 10.000 Atome/Moleküle/cm3 an Wasserstoff im ansonsten noch etwas dünnerem Weltall. Normale Astrofotos zeigen dieses Leuchten sehr stark verstärkt in Rot. Dann kommt oft noch Sauerstoff vor, bei 501nm, das unsere Kameras Blau zeigen. Sterne habe ein kontinuierliches Spektrum, das temperaturabhängig ist. Kühle Sterne sind rötlicher, heiße weiß/blau.

Einen automatischen Weißabgleich wird jede Kameraelektronik überfordern, spätestens dann wenn so gut wie kein neutraler Himmelshintergrund im Bild zu finden ist. Den Weißabgleich macht man eben selbst, zuerst den Hintergrund auf neutral, dann macht man sich einen Umstand zu nutze, der weitgehend passt: Im Durchschnitt sind die Sterne weiß. Heute verfügen wir aber über wesentlich genauere Photometrische Prozesse: Zuerst wird das Bildfeld „astrometriert“ also festgestellt, welchen Ausschnitt am Himmel haben wir vorliegen. Anhand von Leitsternen im Bildfeld deren Lichtzusammensetzung bekannt ist, kann dann das Bild korrigiert werden. Ist eine eigene Wissenschaft, aber man ist zumindest schon mal recht in der Nähe der waren Farben.

Der Rest der Möglichkeiten geht aber dann schon sehr in Richtung Falschfarben. Man kann ja jeden der Farbkanäle beliebigen Kanälen zuweisen oder einmischen. Sehr bekannt die „Hubble Palette“ bestehen aus dem Roten Licht der Wasserstoffs, dem noch tief roteren Leuchten von Schwefel und dem blauen Leuchten des Sauerstoffs. Das hat überhaupt nichts mehr mit dem „natürlichen“ Farbspektrum zu tun, aber man erkennt gewisse Strukturen besser an solchen Falschfarbenbildern. Eine durchaus gängige Praxis im Wissenschaftlichen Bereich.

Massenware

Fotoapparate und Optiken sind Massenware. Das ist nichts negatives, sondern bringt eher Vorteile: Günstiger Preis und recht gleichbleibende Qualität. Dagegen sind „Fernrohre“ ja fast schon Einzelanfertigungen. So passt einfach eine beliebige Fotooptik einfach an den gleichen Anschluss an den Fotoapparat, oder wenn sie einen anderen Anschluss haben, mit einem entsprechenden Adapter. Durch den Anschluss wird u.a. der Richtige Abstand der Linse zum Sensor bestimmt.

Bei Fernrohren ist das schon schwieriger. Man muss den richtigen Abstand schon herausfinden. Ist der falsch, kommt man nicht in den Fokus. Schlimmer noch: Ist der am kurzen Ende und man will dann mal ein Filter dazwischen einbauen, kann es sein, dass man dann eben nicht mehr in Fokus kommt. Die übliche Norm wie 2″ (2 Zoll) oder 1,1/4″ sind lediglich eine Angabe über den Durchmesser und sagt nichts über den notwendigen „Backfokus“ des Systems. Es gibt dann auch noch Linsen, die die Vergrößerung erhöhen (nennt sich Barlow Linsen) aber auch Reduktoren, die die Brennweite verkürzen und damit die Lichtstärke erhöhen. Ob die eigene Optik nicht schon aufgrund mangelnder Öffnung vignettiert steht auf einem anderem Blatt. Da wir mit den FT Sensoren aber einen kleineren Sensor einsetzen ist das nicht ein ganz so großes Thema, wie bei großformatigeren Sensoren. Um eine nicht vermeidbare Bildfeldverzerrung auszugleichen (=runde Sterne bis in die Ecken) gibt es Flattener. Auch hier muss man dann noch den korrekten Abstand zum Sensor finden.

Egal welchen Adapter wir einsetzen: Sind sie sehr gut (und nur solche wollen wir verwenden!) sind sie nicht gerade billig und sie habe ihr genau definiertes Einsatzgebiet. Sie sind sehr spezifisch für ein spezielles Fernrohr (System/Brennweite), an Anderen eben nicht geeignet, auch wenn man sie von den Durchmessern her dazwischen setzen könnte.

Wenn man Glück hat, findet man jemanden, der die gleiche Konstellation zum Laufen gebracht hat oder hat ein Fachgeschäft, dass es abschätzen kann ob es gehen könnte oder geht.

Man kann ansonsten sehr schnell sehr viel Geld versenken…….

Universalität

An sich kann man mit jeder Standard Fotoausrüstung so ziemlich alles versuchen, von Nahaufnahme als auch weite Landschaftsübersichten. Es gibt natürlich dann extra darauf spezialisierte Linsen, aber das hat Zeit. Sie verfeinern halt dann das Ergebnis.

Schwieriger ist es da schon in der Astrofotografie. Da heißt es „jedes Gerät hat seinen Himmel“. Die nutzbaren Brennweiten sind halt begrenzt.

Praktischer Weise wird es aber sowieso schnell dadurch begrenzt, dass es sehr schnell sehr sehr teuer wird, aber nicht nur dass: Es wird sehr schnell sehr sehr unhandlich.

Sind wir mit dem FT Sensorformat bei einer Sensorgröße, bestimmt das unseren Abbildungsmaßstab. Wer Kameras unterschiedlicher Sensorgröße einsetzt, ist hier flexibler, denn er bewegt sich ja bei einem „Cropfaktor“ zwischen x1 (KB/Vollformatsensor) und x2 bei FT Sensoren. Nur der Anspruch an die Optik die ja einen großen Sensor qualitativ gut ausleuchten muss sind natürlich um vieles höher. So ist eine „Cropkamera“ oder unser FT Sensor wohl ein guter Kompromiss.

Für den Einstieg bei größeren Brennweiten kommt an sich sowieso nur dann entweder ein Linsenfernrohr (APO) oder Spiegelteleskop (Newton) in Frage. Damit die Belichtungszeiten pro Bild nicht ausufern sollten sie so Lichtstark wie möglich sein. Nicht außer Acht lassen sollte man, dass mehr Brennweite die Probleme potenziert hinsichtlich geforderter Präzision bei der Nachführung.

Wer allerdings vor hat, sich der Planetenfotografie zu widmen kann sich auch bei RC oder SC Teleskopen umsehen, denn er braucht so viel wie möglich Brennweite, Lichtstärke spielt hier eine Untergeordnete Rolle. Und er kann den Fotoapparat eher vergessen: Es braucht andere Kameras und eine Laptop um möglichst viele Bilder der kleinen aber sehr hellen Planeten zu sammeln.

Für die verschiedenen Objekttypen braucht es dann oft auch komplett andere Methodik der Bildgewinnung und deren Aufbereitung zur finalen Ausarbeitung. Das macht man nicht mehr so auf die Schnelle…. Man wird nur richtig Gut wenn man sich längere Zeit intensiv damit beschäftigt. Und wie immer: Auch in Übung bleibt.

Zeitaufwand

Fotografie an sich geht sehr schnell. Will man aber dann noch die Bildidee weiter verbessern, wird man um ein genaueres Planen nicht herumkommen.

Outdoor wir es dann auch in der „normalen“ Fotografie aufwändig: Der Sonnenstand, die Jahreszeit will geplant sein. Das ist aber (leider) meist nicht mehr so üblich, aber wird meist der Unterschied zwischen Knipsbild, guten Bild oder Wahnsinnsbild sein.

Bei der Astrofotografie kommt man aber sehr schnell drauf, in größeren Zeiträumen zu denken. Je weniger mobil man sein kann, desto mehr ist man angewiesen, dass zum Richtigen Zeitpunkt alles passt.

Bei Deep Sky ist ein dunkler Himmel Voraussetzung (zumindest für den Einsteiger). Den gibt es nur außerhalb von Städten und nur während mondloser Nächte. Dazu muss es auch frei von Wolken oder Dunst sein. Das „Seeing“ sollte auch stimmen, vor allem bei Planeten und Mondfotografie. Im Jahreszeitlichen verlauf sehen wir nur bestimmte Teile des Sternhimmels. Der Rest ist da, wo dann die Sonne gerade steht und ist daher in der Dämmerung und am Tag natürlich nicht mehr erreichbar. Ebenso schwankt über das Jahr die Tageslänge.

Im Winter ist es sehr lange dunkel, aber leider meist sehr dunstig und feucht. Liegt Schnee, ist es selbst in Neunmondnächten bedingt durch die Lichtverschmutzung sehr hell. Das Frühjahr ist die beste Zeit, was Seeing betrifft und die Luft recht drocken. Im Sommer wird es gerade mal für 1-3 Stunden dunkel genug, im Norden Europas dann nie.

Weil aber ein Bild aus möglichst vielen Belichtungen zusammengesetzt werden, ist es egal, wann sie gemacht wurden. Man kann also Belichtungen über Tage/Wochen/Monaten/Jahren verwenden. Selbst von verschiedenen Geräten.

Der Himmel ist voll von tollen Objekten, aber die richtig Großen findet man im Süden in Milchstraßennähe. Objekte in Horizontnähe gehen im Dunst unter. Um sie genügend hoch am Himmel zu haben muss man schon sehr weit südlich, besser auf die südliche Halbkugel fahren. Da hin zu fahren, mitsamt seinen 50-70kg Ausrüstung wird schwierig und teuer. Fehlt ein entscheidendes Teil – geht nichts. Daher ist hier der gangbarste Weg: StarAdventurer ins Reisegepäck und mit Fotolinsen Widefieldbilder. Oder auf eine der „Astrofarmen“ nach Namibia oder in die Alpen und die Geräte mieten.

Mittlerweile gibt es aber auch um die Erde verteilt Remote Sternwarten. Je nach Gerätschaften ergibt sich dann ein Preis den eine Stunde Belichtungszeit kostet, so gegen 80-100 US$). Das hat den Vorteil, man greift bequem via Internet zu, erstellt den Job. Während man schläft, werden die Bilder angefertigt und sind dann versandbereit.

Wozu das Ganze?

Ein verbindender Aspekt ist wohl der: „Es geht nichts über ein selbst gemachtes Bild“

Denn perfekte Bilder in hoher Auflösung kann man im Internet mittlerweile überall recht leicht bekommen….